AI-geddon, część 1: Czym jest AGI

Ten tekst miał się nazywać "Dlaczego AGI nas nie zniszczy". Chcąc się doedukować obejrzałem paręnaście godzin podcastów o AI które bardzo wzbogaciły moją perspektywę i przewartościował podejście do tego tematu. Wydaje mi się, że na dziś w dyskursie da się wyodrębnić trzy nurty:

- tech-bro utopia, czyli taka star trekowa wizja świata w której wszystkie problemy są rozwiązane, ludzie dominują galaktykę a inteligentne roboty służą ramie w ramię z ludźmi Gwiezdnej Flocie.

- dystopijny AIgeddon, czyli taka w której roboty z Matrixa to patałachy bo w niej znikamy z powierzchni planety i tyle.

- sceptyczny overhajpizm, czyli taki który uważa, że AI to tak zwany flavor of the week - kolejny sezonowy temat z którego będzie więcej szumu niż efektu.

Ile tematów przychodzi Ci do głowy które posiadają tak diametralne w skali ludzkości konsekwencje? Wystarczy zgodzić się, że każdy z tych nurtów ma niezerową szanse na realizacje by stwierdzić, że jest to temat godny debaty.

Czym jest AGI

Czasami też nazywana silną sztuczną inteligencją, (strong AI). Najprościej mówiąc, jest to sztuczna inteligencja która osiąga poziom wiedzy, poznawczy zdolny do wykonywania zadań z taką samą lub lepszą sprawnością niż człowiek. W praktyce, gdy mówimy o AI - czyli de facto programie komputerowym rozumiemy szereg przewag nad rozwiązaniem biologicznym od szybkości wykonywania operacji po skalowanie (nie możemy w razie potrzeby dostawić "drugiego" mózgu jak dodatkowego serwera). Jeśli AI osiągnie poziom człowieka oznaczać będzie, że potrafi się ulepszać pisząc swój kod.

Iskra Silnej Sztucznej Inteligencji

W 150 stronicowej publikacji "Sparks of Artificial General Intelligence: Early experiments with GPT-4" firmowanej przez korporacje Microsoft - poza, prowokującym tytułem, pojawiają się mocna teza mówiąca o tym, że biorąc pod uwagę szerokie możliwości modelu GPT-4 można uznać, że jest to wczesna wersja silnej sztucznej inteligencji.

Given the breadth and depth of GPT-4's capabilities we believe that it could reasonably be viewed as an early (yet still incomplete) version of an artificial general intelligence (AGI) system.

Cały dokument przechodzi przez wiele aspektów analizując jak GPT-4 radzi sobie z różnymi wyzwaniami. Wyniki są bardzo dobre. Dalej model ma problemy z halucynacjami (zmyśla) oraz matematyką, ale w przytłaczającej liczbie przypadków osiągane wyniki są na poziomie człowieka. W mojej, absolutnie amatorskiej, ocenie jest to trochę tekst marketingowy. Historycznie Microsoft w dziedzinie AI ustępował Googlowi i strategiczne partnerstwo z OpenAI daje okazję na wizerunkowe odbicie się.

Gówniana książka

Sam Altman, CEO OpenAI powiedział, że GPT-4 uważa za wspaniałe osiągnięcie to zdecydowanie nie dostrzega tam błysku AGI.

Gdybym czytał książkę Sci-Fi i była tam postać będąca AGI i ta postać to byłby ChatGPT... to uznałbym to za gównianą książkę

Ta krótka, zabawna anegdotka wypełnia definicje AGI z kategorii "będę wiedział, że to AGI gdy ją zobaczę".

Eliezer Yudkowsky w podcaście Lexa Friedmana użył analogii szybkości by przedstawić superinteligencje. By lepiej wczuć się w nią sugeruje byśmy wyobrazili sobie, że jako Ziemianie odkrywamy, że żyjemy w pudełku zbudowanym przez obcych - gdy z niego wychodzimy do ich świata (Internet) to okazuje się, że są straaaaasznie wolni. Jeden "dzień" u nich to dekada naszego czasu - czasu podczas którego dalej prowadzimy badania i odkrywamy nowe wynalazki. Okazuje się, że nawet jeśli są istotnie potężniejsi, to nie mają z nami szans bo są straaaasznie powolni. Analogią uzupełniającą - która bardzo do mnie przemówiła - były drzewa. Jest to jakaś populacja która istnieje znacznie dłużej niż człowiek i nagle w mgnieniu oka pojawia się taka zaraza która zaczyna dziesiątkować drzewa z jakiegoś nieznanego powodu.

Może to nie takie trudne?

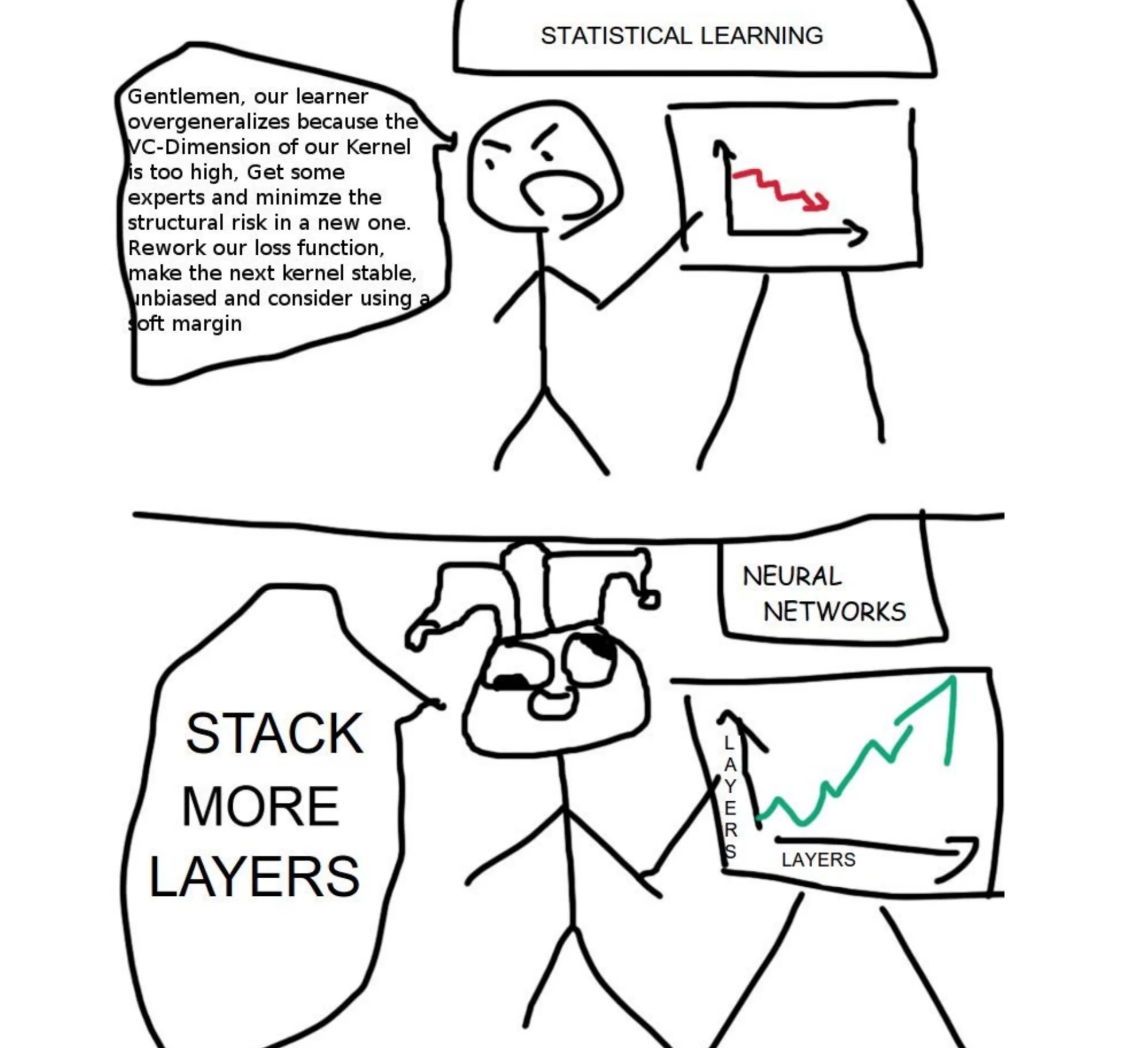

Stworzenie AGI wydaje nam się trudne bowiem nawet nie mamy dobrze zbadanego naszego mózgu. Jak zatem moglibyśmy stworzyć tak zaawansowaną maszynę? Max Tegmark zauważa, że zbudowanie mechanicznego ptaka, który macha skrzydłami by latać zajęło sto lat więcej niż zbudowanie samolotu - natura ma szereg ograniczeń czy wymogów które musi spełnić takich jak brak zewnętrznego konstruktora, dostępność pierwiastków czy samonaprawianie się. Bez tych ograniczeń człowiek potrafił osiągnąć analogiczny efekt - lot - w inny, prosty sposób. Można powiedzieć, że potrafimy "zasypać" problem zasobami. Pod kątem energetycznym lot ptaka jest bardziej efektywny niż lot samolotu.

Analogicznie w przypadku AI być może osiągnięcie zdumiewających wyników nie wymaga bardzo skomplikowanych nakładów. Być może operując na obecnej architekturze wystarczy wprowadzać drobne poprawki i zwiększać liczbę parametrów, warstw, neuronów, danych czy co tam jest innego ważnego. Zasypać problem zasobami. Być może AGI nie jest tak odległą wizją?

Instrukcja obsługi Silnej Sztucznej Inteligencji

Max Tegmark wylicza trzy rzeczy, których nie powinniśmy robić w kontekście AI:

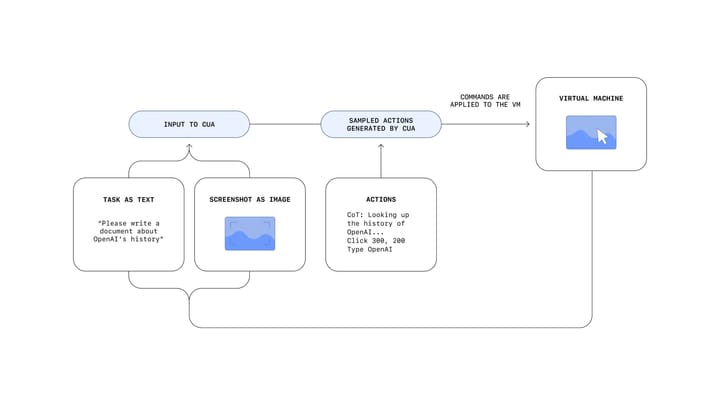

- Nie uczmy jej programować - otwiera to możliwość niekontrolowanego rozwijania jej możliwości przez siebie samą. Jak wiemy, ten punkt jest spalony - mamy bardzo dojrzałe produkty które świetnie się spisują w tworzeniu całych aplikacji.

- Nie podłączajmy jej do internetu - według pesymistów, zamknięcie AGI w nieprzepuszczalnym systemie jest szansą na unieszkodliwienie jej. Internet daje możliwość skopiowania siebie na inny serwer, manipulowania ludźmi poprzez komunikację online. To oczywiście też zrobiliśmy.

- Nie uczmy jej o psychologii człowieka - o naszych błędach poznawczych, o tym jak je można wykorzystywać. Jaka jest nasza natura, mocne i słabe strony. Nie znamy precyzyjnie zestawu danych na których np. GPT-4 jest uczony, ale nic nie sugeruje by ten obszar był wykluczony. Dodatkowo istnieją całe modele rekomendacji, zazwyczaj stosowane w social media, które de facto uczą się tego czym kieruje się człowiek.

Więc ten pociąg odjechał.

Część 2: Dobrze wychowaj swojego robota

Od czego więc zależy czy zrealizuje się wizja tech-bro utopii czy dystopijny AIgeddon? Alignment, literalnie oznacza dopasowanie a w kontekście AI oznacza nurt badań nad bezpieczeństwem sztucznej inteligencji oraz dopasowaniem jej celów do celów ludzi. O tym jakie są wyzwania w tym obszarze przeczytasz w części drugiej tego minicyklu.