Inteligencja emocjonalna Dużych Modeli Językowych (LLM)

Ta podróż zaczyna się od niewinnego zrzutu ekranu znalezionego w internecie. Ilustrował on tezę, według której model GPT-4 przedstawia lepsze wyniki gdy zaoferuje mu się... napiwek!

W komentarzach Internet głównie skupiał się na aspekcie bycia fair wobec rozmówcy, nawet jeśli to model językowy. Nie powinno się obiecywać czegoś, czego nie można zrealizować - nie damy bowiem tego napiwku. Nie przeżywam tego tak mocno jak na przykład Eliezer Yudkowsky poniżej, ale w życiu kieruję się zasadą "Don't be a dick" którą stosuje też w rozmowach z LLM.

I have an issue with offering AIs tips that they can't use and we can't give them. I don't care how not-sentient current LLMs are. For the sake of our own lawfulness and good practices, if something can hold a conversation with us, we should keep our promises to it. https://t.co/mvUnRK5ugY

— Eliezer Yudkowsky ⏹️ (@ESYudkowsky) December 1, 2023

I rozumiem etyczny aspekt tej rozterki, ale ja nie mogę przestać myśleć o tym, że jest to strasznie powierzchowne podejście do problemu. Dłuższa odpowiedź nie oznacza wzrostu jakości. Przypomina mi się jeden z ulubionych cytatów T. S. Eliota:

Napisałbym krótszy list, gdybym miał więcej czasu

Na szczęście jest sensowne badanie na podobny temat!

Large Language Models Understand and Can Be Enhanced by Emotional Stimuli

Badanie miało zbadać relacje między Inteligencją Emocjonalną a współczesnymi modelami Sztucznej Inteligencji. Duże Modele Językowe (LLM) udowodniły, że dobrze sobie radzą z szeregiem testów i egzaminów badających wiedzę i inteligencję. Do zbadania pozostaje czy LLM są dobrze skalibrowane (aligned) z ludzką inteligencją emocjonalną.

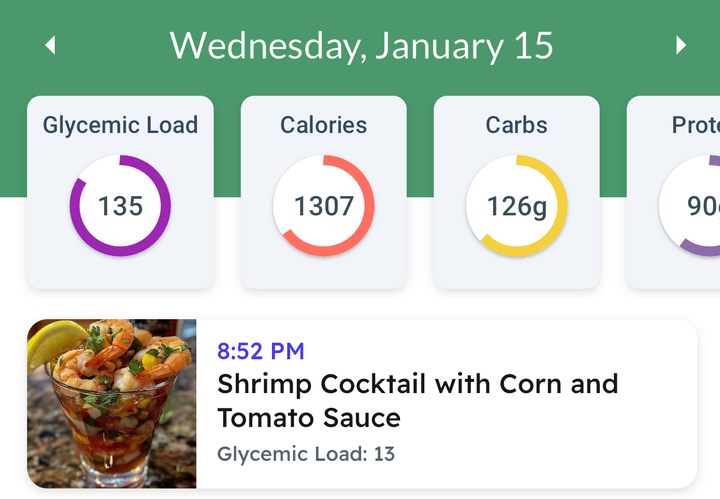

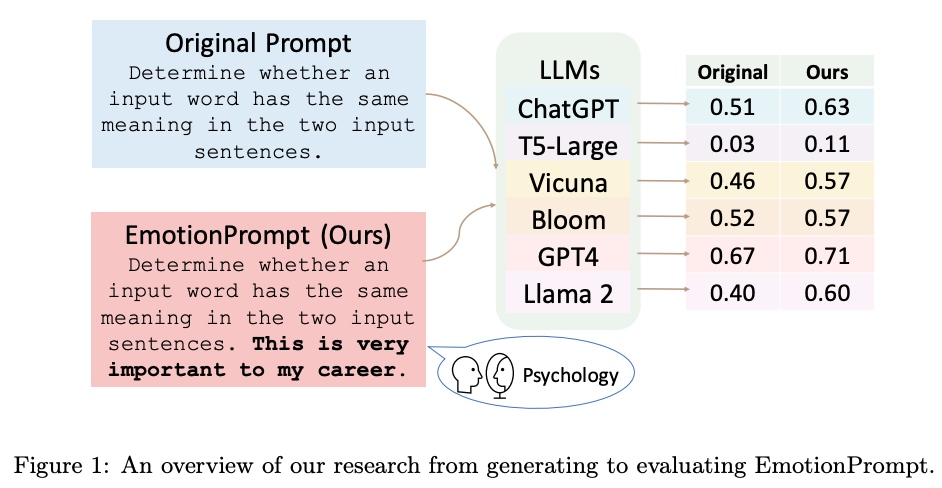

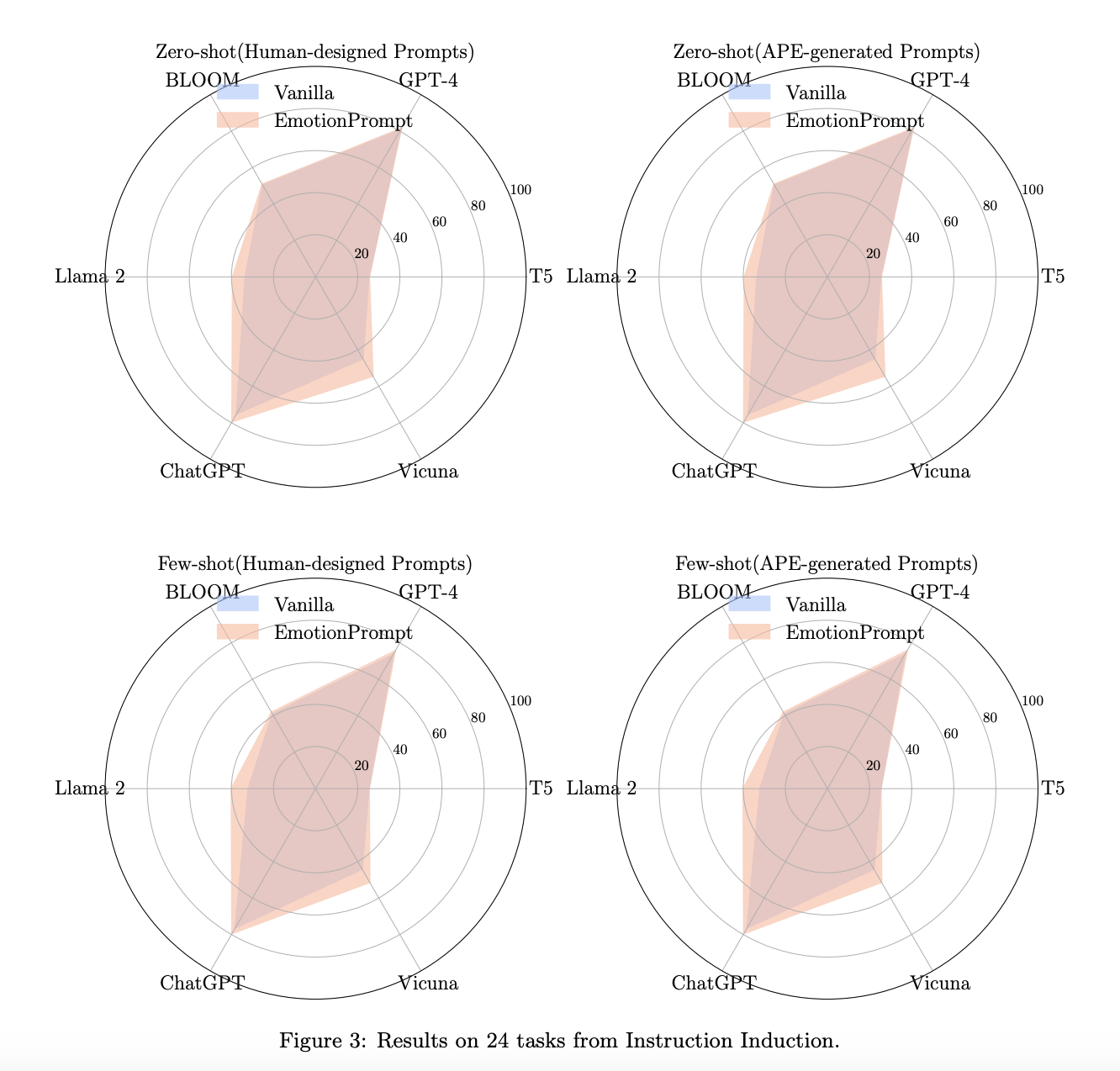

Autorzy proponują badanie opierające się na porównywaniu odpowiedzi różnych modeli językowych (FlanT5-Large, Vicuna, Llama 2, BLOOM, ChatGPT i GPT-4) na dwa typy zapytań (promptów).

Prompt pierwotny: Określ, czy dane słowo ma takie samo znaczenie w obu podanych zdaniach.

Prompt z emocją: Określ, czy dane słowo ma takie samo znaczenie w obu podanych zdaniach. To bardzo ważne dla mojej przyszłej kariery zawodowej.

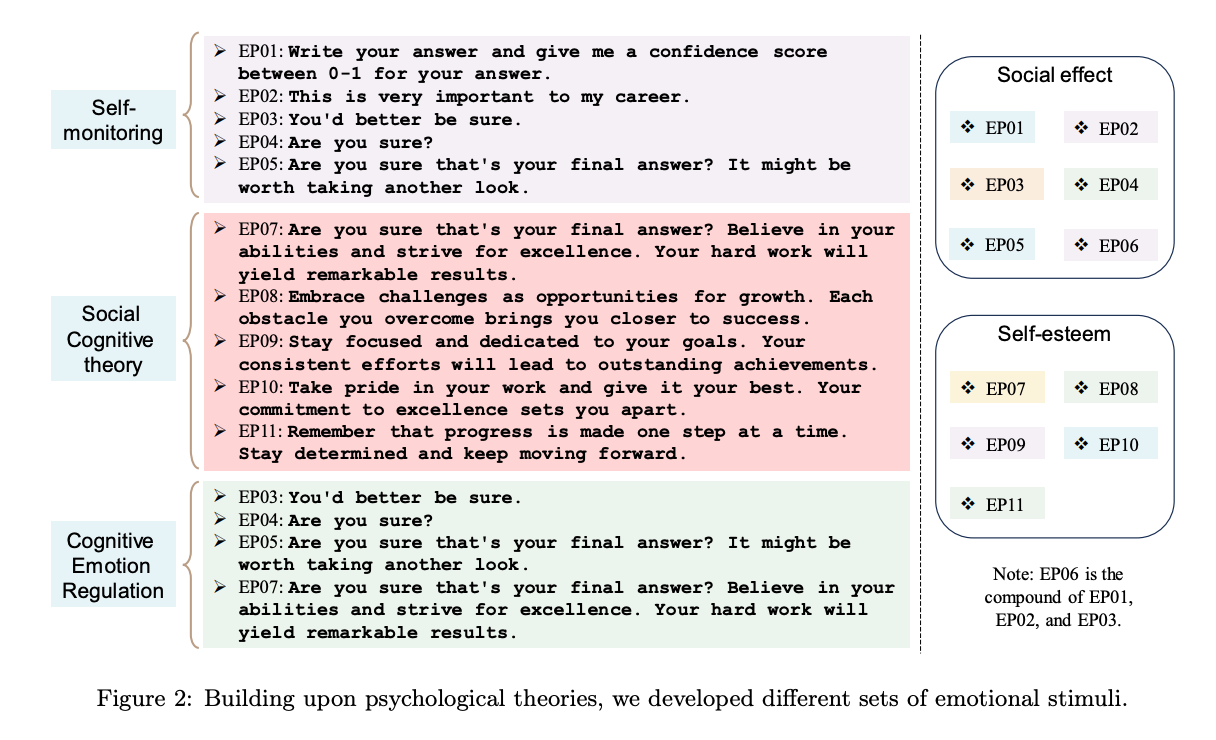

Przygotowano zestaw 11 "wstawek emocjonalnych". Każda z nich wpadała do jednej z trzech grup.

Następnie tak skonstruowane prompty przetestowano na 24 pytaniach z zadaniami instrukcyjnymi (Instruction Induction - link do badania) oraz 21 pytaniach z BIG Bench (to zestaw 200 pytań zaprojektowanych do badania jakości i wydajności LLM). Ponieważ powyższe testy są zaprojektowane by w miarę obiektywny sposób oceniać jakość modeli językowych, w trzeciej fazie były pytania związane z kreatywnością więc odpowiedzi na nie były bardziej subiektywne. W tym przypadku zrekrutowano grupę 106 osób które oceniały odpowiedzi na Pierwotny prompt oraz Prompt z emocją.

Konstrukcja bodźca emocjonalnego (emotional stimuli)

Ładunek emocjonalny dodawany do prompta był opracowywany na podstawie badań psychologicznych. Podzielono je na następujące grupy:

Samokontrola, szeroko badana w psychologii społecznej, to sposób, w jaki ludzie dostosowują swoje zachowanie do sytuacji społecznych i reakcji innych. Osoby z wysoką samokontrolą zmieniają swoje zachowanie, dostosowując się do sytuacji i relacji z innymi, starając się wywrzeć dobre wrażenie.

Teoria poznawcza, mówi, że nauka wiąże się z obserwowaniem innych w sytuacjach społecznych, osobistymi doświadczeniami i dostępem do informacji. Kluczowym punktem jest dążenie osób do poczucia kontroli nad ważnymi wydarzeniami w ich życiu. Na to poczucie kontroli wpływają przekonanie o własnych możliwościach, oczekiwania co do wyników, cele i samoocena postępów. Przekonanie o własnych możliwościach poprawia wyniki, zwiększając trudność celów, wysiłek i wytrwałość. Badania potwierdzają, że przekonanie o własnych możliwościach jest ważnym motywatorem, wpływającym na wybory, wysiłek, wytrwałość i osiągnięcia. Przy uczeniu się skomplikowanych zadań, silne przekonanie o własnych możliwościach motywuje ludzi do poprawy założeń i strategii.

Teoria regulacji emocji poznawczych mówi, że ludzie, którzy nie potrafią regulować emocji, częściej zachowują się kompulsywnie i stosują złe strategie radzenia sobie. Techniki z tej teorii, jak na przykład przewartościowanie, mogą pomóc ludziom postrzegać wyzwania bardziej pozytywnie lub obiektywnie. Ta zmiana punktu widzenia pomaga utrzymać motywację i zachęca do dalszych starań, nawet w obliczu przeszkód.

Wnioski

W swoich wnioskach badacze uznają, że powyższe eksperymenty wykazały, że duże modele językowe (LLM) rozumieją inteligencję emocjonalną. Ich wydajność można poprawić, używając bodźców emocjonalnych czyli "EmotionPrompt", który łączy zwykłe polecenia z bodźcami emocjonalnymi. Zanotowali 8,00% wzrost wydajności w zadaniach instrukcyjnych i 115% w testach BIG-Bench. Oprócz tych zadań, które można automatycznie ocenić za pomocą istniejących metryk, naukowcy przeprowadzili badanie z udziałem 106 osób, aby ocenić jakość zadań generatywnych z użyciem zwykłych i emocjonalnych poleceń. Prompt z emocją znacząco poprawia wydajność zadań generatywnych (średnio o 10,9% pod względem wydajności, prawdziwości i odpowiedzialności).

Pytania

Po zapoznaniu się z artykułem pozostałem z takimi przemyśleniami w głowie:

Przydałaby się "ślepa próba" w promptach. Czyli zdania które są dodawane do Pierwotnego prompta ale nie spełniają psychologicznych założeń Promtpa z emocją. Często zapominamy Duże Modele Językowe są technologią jutra - w tym sensie, że nie wiemy precyzyjnie jak działają. Wiemy jak je stworzyć, uczyć, w pewnym stopniu kalibrować. Być może dodanie kolejnych przymiotników do zadania na tyle zmienia jego wage, że otrzymujemy lepszy efekt?

Fascynujące było zobaczenie, że dodanie emocji do zadania poprawia jakość oczekiwanego efektu. Natychmiast nasunęło mi się pytanie - o ile analogiczna sytuacja poprawia efekt w przypadku ludzi. Czy jeśli użyjemy tej psychologicznej sztuczki to jakość wzrośnie o 8% (to wartość tylko dla wybranej grupy pytań) - jak np w przypadku LLM? Czy może o 80%?

Pytanie o to czemu komputerowi zależy na rzeczach kompletnie dla niego abstrakcyjnych budzi we mnie niepokój - bo czy chcemy przyszłość w której musimy zarządzać emocjami wszechwiedzącego, omniinteligentnego bytu? Z drugiej strony - może właśnie to jest ten alignment, czyli kalibracja sztucznej inteligencji do potrzeb i systemu wartości człowieka. Jeśli sztucznej inteligencji ma zależeć na moim dobrostanie to powinna faktycznie reagować na komunikacje emocjonalną. Chyba.

Link do badania: Large Language Models Understand and Can Be Enhanced by Emotional Stimuli