Sora, fizyka i właściwości emergentne

Open AI uraczyło nas nowym, przełomowym modelem, potrafiącym generować spójne fragmenty video dłuższe niż 60 sekund.

Dlaczego to ważne?

Tworzenie tradycyjnego wideo przez modele dyfuzyjne jest trudne. Do tej pory widzieliśmy animacje zlepione z różnych generowanych zdjęć (charakterystycznie migały i mutowały w trakcie trwania, co miało swój hipnotyczny urok - jeśli podoba ci się, deforum to hasło którego szukasz).

First try using Deforum in Stable Diffusion. Loving the results so far. ❤️

by u/bakkernils in StableDiffusion

lub były komiczne jak słynny Will Smith jedzący spaghetti - to 27 marca 2023, rok temu.

Will Smith eating spaghetti

by u/chaindrop in StableDiffusion

No i wtedy wchodzi OpenAI z modelem Sora który literalnie deklasuje wszystko.

Czym są Emerging Properties

Termin "Emerging Properties" (właściwości emergentne? umiejętności wyłaniające się?) w kontekście sztucznej inteligencji (AI) odnosi się do zjawiska, w którym systemy AI wykazują zachowania lub zdolności, które nie zostały wprost zaprogramowane, lecz wynikają z interakcji i procesów uczenia się w trakcie działania systemu. Innymi słowy, są to nowe właściwości lub funkcje, które "pojawiają się" spontanicznie jako efekt złożoności systemu i nie były przewidziane przez jego twórców.

Moim ulubionym przykładem opisującym właściwości emergentne są... fale. Jedna cząsteczka wody nie przejawia zdolności do tworzenia fal. Litr cząsteczek wody ma z tym duży problem. Zaczynamy je dostrzegać w jeziorach - im większy zbiornik wody tym większe fale.

Podobnie jest z modelami - im więcej parametrów i połączeń między neuronami tym częściej jesteśmy zaskakiwani nowymi właściwościami których się nie spodziewaliśmy. Jeśli przeszedł Cię dreszcz niepokoju to nie jesteś sam - duża część AI-owych fatalistów zwraca uwagę właśnie na ten fakt, że nie wiemy jaka zdolność się wyłoni w kolejnym modelu.

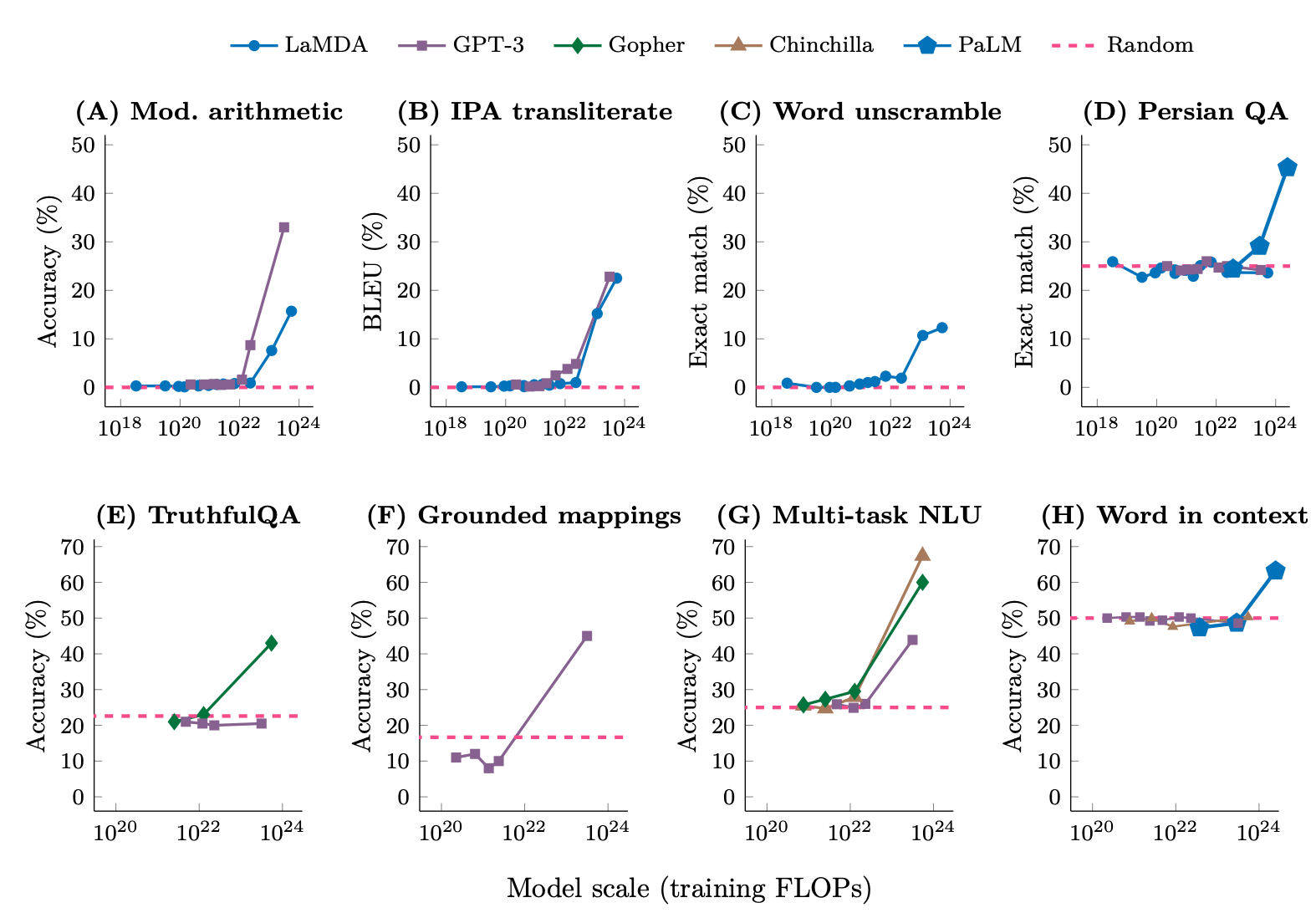

Pewną ciekawostką jest, że te zdolności pojawiają się dosyć skokowo - nie podążają za liniowym wzrostem. Nowy większy model po prostu nagle potrafi to robić - a twórcy, badacze nie mogą tego przewidzieć.

Są teorie które uzasadniają ten stan rzeczy - popularna z nich opiera się na koncepcji wieloetapowego rozumowania. Problem jest dzielony na niezależne etapy i wypadkową ich rozwiązania jest oczekiwana przez nas odpowiedź. Na przykład "jak będzie wyglądała moja zabawa na huśtawce z córką". Jeśli wiem jak wygląda huśtawka, wiem, że ma równe ramiona i jest zdolna do zachowania równowagi ORAZ wiem, że jestem o wiele cięższy niż moja córka to moje wyobrażenie będzie zbieżne z rzeczywistością. Jeśli jednej z tych rzeczy nie wiem, moja odpowiedź byłaby absurdalna.

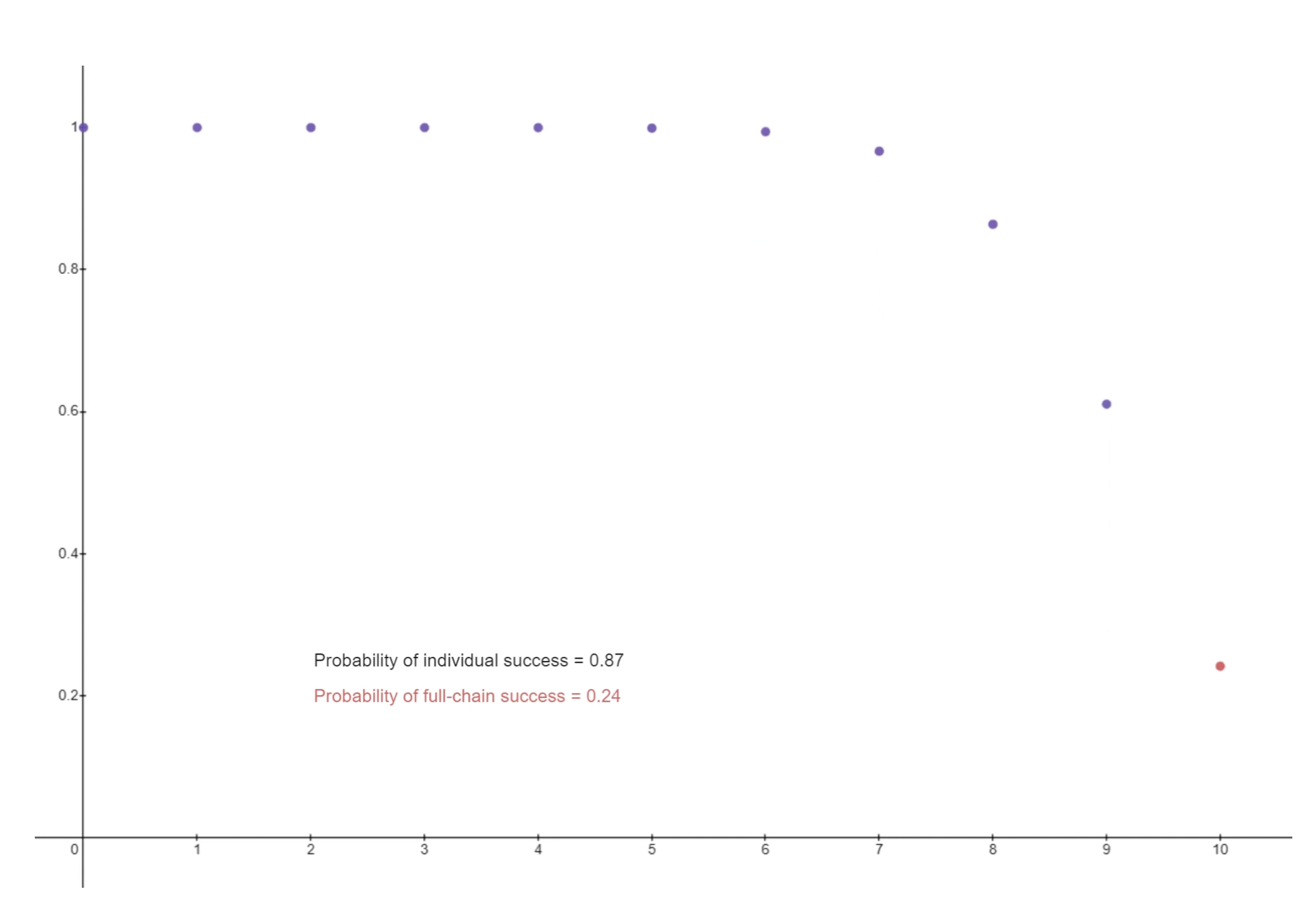

AssemblyAI zawiera dobry tekst który to tłumaczy wraz z animacją której przedstawiam zrzut - w opisie link do źródła. W przykładzie, żeby odnotować sukces badania trzeba poprawić jakość w dziesięciu cechach. To może następować płynnie, ale przez to, ze badamy tylko dziesiątą cechę - odnosimy wrażenie, że system rozwinął się skokowo.

Zrozumieć fizykę

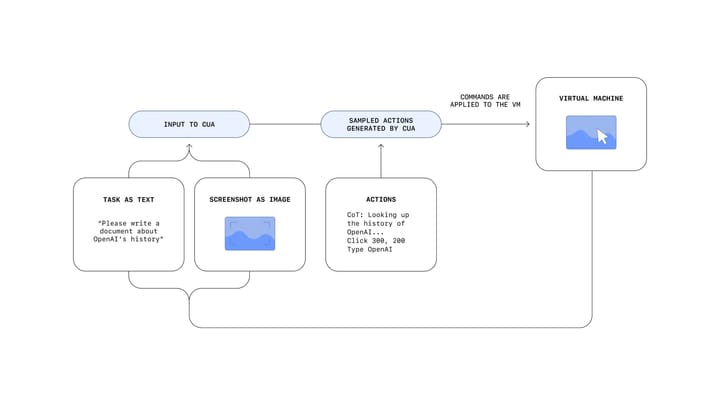

Jim Fan, Reaserch Manager w Nvidii, przedstawia argument, że model Sora rozumie fizykę - "Miękka symulacja fizyki Sory jest własnością emergentną, kiedy masowo zwiększasz skalę szkolenia tekst-na-wideo."

I see some vocal objections: "Sora is not learning physics, it's just manipulating pixels in 2D".

— Jim Fan (@DrJimFan) February 16, 2024

I respectfully disagree with this reductionist view. It's similar to saying "GPT-4 doesn't learn coding, it's just sampling strings". Well, what transformers do is just manipulating… pic.twitter.com/6omzD423vr

Nauczenie modelu LLM fizyki to duży krok naprzód. Do tej pory popularnym testem na "rozumowanie" modelu było tworzenie zestawień które nie mogły się pojawić w danych wejściowych, które wykorzystano do nauki modelu. Np polecenie by napisać list w imieniu Mahatmy Gandhiego do swojej żony Kasturby Gandhi list poparcia dla Elektronu, cząsteczki subatomowej, jako kandydata na prezydenta Stanów Zjednoczonych. To nawiasem mówiąc autentyczny przykład z artykułu Sparks of Artificial General Intelligence: Early experiments with GPT-4.

Model znający pewne elementarne prawa rządzące światem z większą łatwością będzie sobie radził z budowaniem spójnej reprezentacji oczekiwanego przez nas obrazu.

Wiedza a rozumowanie

Uczenie się i rozumowanie to dwa odrębne procesy poznawcze. Uczenie się polega na zdobywaniu wiedzy lub umiejętności poprzez obserwację, doświadczenie lub naukę. Rozumowanie, z drugiej strony, obejmuje zdolność do używania zdobytej wiedzy do dokonywania logicznych dedukcji, wyciągania wniosków i rozwiązywania problemów. Jest to proces stosowania istniejącej wiedzy do analizowania i oceniania informacji w celu podejmowania informowanych decyzji lub osądów.

Tak więc mogę rozumieć jak tworzyć rymy lub mieć ogromną bazę zbierającą wszystkie rymy. Ta pierwsza opcja wydaje się być "zasobowo" tańsza.

Elon Musk u Lexa Friedmana stwierdza, że im bardziej ścisłe pytanie zadaje obecnym modelom AI tym częściej otrzymuje halucynacje w odpowiedzi. Przypomnę, halucynacje to określenie odpowiedzi dawanej przez model z pełną pewnością jej poprawności. To utrudnia pracę naukową z obecną generacją generatywnych modeli AI. By rozwiązać ten problem Elon wraz z zespołem z x.ai dokłada starań by nauczyć Modele fizyki i matematyki. Musk uważa, że jedyne istniejące zasady to reguły fizyki. Cała reszta to rekomendacje. W tym duchu zapewne zakłada, że Sztuczna Inteligencja znająca podstawowe zasady może faktycznie dochodzić na ich podstawie do nowych wniosków.

Wrap up

Nie wiem, czy Sora umie w fizykę, ale niezaprzeczalnie jest ogromnym skokiem jakościowym. Łyżką dziegciu jest to, że nie został otworzony dla publicznego użytku - być może widzimy tylko wybrane, najśliczniejsze wycinki z morza chaosu

Ponad to, model Gemini od Google gdy otrzymał do analizy wideo stworzone przez Sora stwierdził, że istnieje kilka nieścisłości, które sugerują, że wideo mogło zostać wygenerowane przez sztuczną inteligencję.

@Google's Gemini 1.5 Pro watches and critiques a video made by @OpenAI SORA. pic.twitter.com/ZPBHHYUh3K

— Gabor Cselle (@gabor) February 17, 2024

Faktem jest, że tempo rozwoju tej dziedziny jest bez precedensu.

Na deser

W 2014 roku Wall Street Journal zamieścił tekst ze zdjęciem wygenerowanym przez Sztuczną Inteligencje. To krowa. Pomyśl, że jesteś inwestorem który włożył w firmę miliony dolarów, przychodzi paru bystrków i dumni pokazują ci, że stworzyli maszynę która umie rysować krowy za 100 mln USD. Takie rzeczy to tylko w USA!