Przyszłość Open Source AI

Jakiś czas temu światło dzienne ujrzał dokument zawierający wewnętrzną opinię jednego z pracowników Google o wyścigu zbrojeń między Googlem a OpenAI w kontekście rozwoju modeli sztucznej inteligencji:

We [Google] aren’t positioned to win this arms race and neither is OpenAI. While we’ve been squabbling, a third faction has been quietly eating our lunch.

Fosa (moat) to w żargonie produktowym określenie atrybutów budowanego rozwiązania które sprawią, że nasza aplikacja będzie trudna do skopiowania. Na przykład fosą w Spotify są playlisty które trudno wyeksportować oraz algorytm który co tydzień podpowiada nam nowe kawałki bo zna nasze gusta muzyczne. Budując produkt zawsze staramy się wykopać jak najszerszą fosę by konkurencji trudno było skraść uwagę naszych Użytkowników. Apple może wydać miliony by stworzyć aplikacje lepszą od Spotify, ale nie ma takich pieniędzy by poznał gusta muzyczne użytkowników konkurencyjnej aplikacji z ostatnich paru lat. To dobra fosa.

Cytowany Googler uważa, że właśnie przez brak fosy ostatecznym wygranym będą modele otwarte. Oznacza to, że korporacja nie ma wiele wartości do dodania do ostatecznego produktu. Społeczność może go "nadgonić" a przez zbiorową kreatywność wykoncypować bardziej efektywne podejście. Modele Open Source obecnie są uznawane za mniejsze i słabsze, ale dzięki temu ich uczenie jest znacznie tańsze. Często jest tak, że ograniczenia wyzwalają kreatywność - i chyba dzieje się podobnie w AI. Jeśli problemu nie można zasypać serwerami, trzeba wymyślić inne podejście.

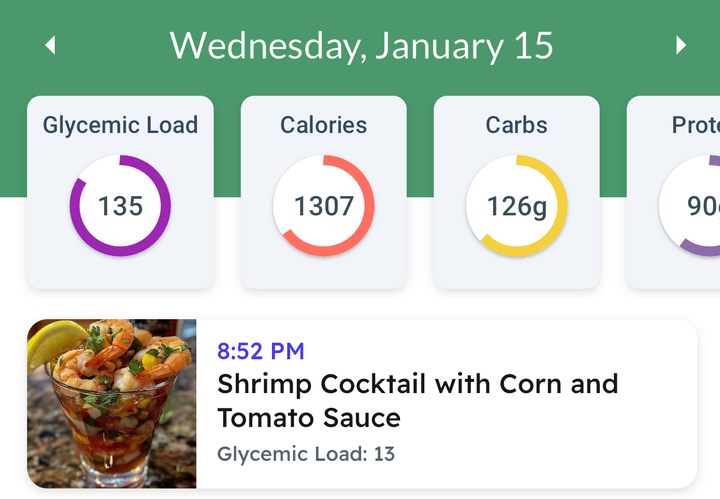

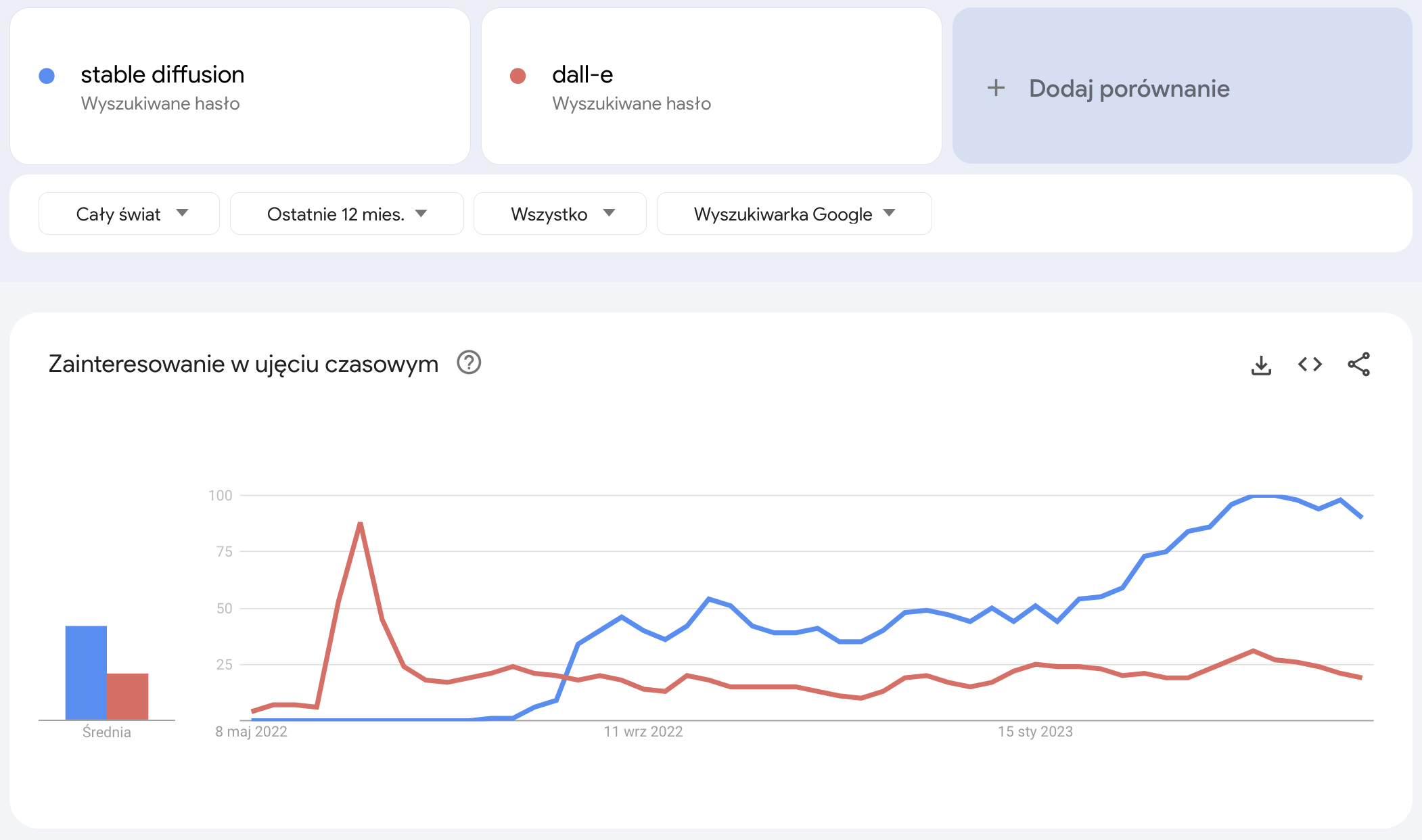

Autor dokumentu zwraca uwagę, że podobna sytuacja miała miejsce w obszarze generowania grafik przez sztuczną inteligencję. Początkowo Dall-e podbił internet szturmem ale to Stable Diffusion, otwarty model od StabilityAI, obecnie zdaje się być popularniejszy - wprawdzie trudno to zmierzyć, ale wrzucając obie nazwy w Google Trends wydaje się mieć to potwierdzenie.

Zagrożenia Open Source

Sporo o zagrożeniach i bezpieczeństwie modeli AI pisałem w cyklu o zaczepnym tytule AI-geddon. Wnioski płynące z nich podniesione są do kwadratu gdy pomyślimy, że modele sztucznej inteligencji mają być udostępniane na zasadzie Open Source. Co do zasady obecnie dosyć skutecznie kontrolujemy wiedze jak szkodzić ludziom. Nikt nie ma chyba wątpliwości, że sztuczna inteligencja może być szkodliwa w niepowołanych rękach. Pomijam kwestie AGI, chodzi tu o szerzenie dezinformacji, wykorzystywanie jej do tworzenia złośliwego oprogramowania, włamywania się do systemów informatycznych, tworzenia wyrafinowanych sztuczek socjotechnicznych choćby z imitacją głosu bliskiej osoby.

Wspomniany Stable Diffusion jest udostępniony na otwartej licencji Creative ML OpenRAIL-M która zabrania wykorzystywania modelu w celach niezgodnych z prawem, do oczerniania innych, dręczenia, wykorzystywania nieletnich, dawania porad medycznych, tworzenia dowodów sądowych, dyskryminacji... lista jest dłuższa. Ale fakt, że jest to oprogramowanie otwarte oznacza, że ograniczenia narzucone przez licencjonodawcę mogą być w praktyce ominięte przez użytkownika.

Czy otwierać kod?

Jest nieco złośliwości adresowanych do OpenAI, że ich najnowsze modele wcale nie są Open Source. W podcaście Lexa Fridmana, Sam Altman, CEO Open AI pytanie o to czemu nie otwiera kodu najnowszych modeli sparował odpowiadając: A czy ty byś otworzył? Dorozumiana teza w tym pytaniu brzmi: rozumiemy, że AI wymaga kontroli. Dlatego trzymamy ją zamkniętą. Tę myśl podkreśla Yuval Harari w wywiadzie twierdząc, że AI nie jest takie jak inne wynalezione narzędzia. Do tej pory to człowiek decydował, czy użyje - powiedzmy - noża do czegoś pożytecznego czy złego. Nóż nie decydował. Nawet parkując kwestie świadomości sztucznej inteligencji to i bez tego aspektu to szalenie potężne narzędzie.

Sam Altman zapytany, czy GPT posiada wyłącznik z którego można skorzystać w wypadku buntu maszyn odpowiada bez zwłoki: tak. Przy okazji przywołuje bartwną anegdotę, czemu pierwszy iMac miał rączke w obudowie. Ponoć Steve Jobs miał mawiać, że daje mu to poczucie komfortu: w ostateczności jest to maszyna, mogę wziąć ją i wyrzucić przez okno.

Open Source to plastyczność i decentralizacja. Z tego wynika, że przysłowiowy Zły Aktor z jednej strony może skupić się na rozwijaniu negatywnych, szkodliwych społecznie cech modelu. Z drugiej strony - może usunąć wyłącznik.

Emad Mostaqu, CEO firmy Stability AI odpowiedzialnej za otwarty model Stable Diffusion, argumentuje, że korzyści płynące z wykorzystania sztucznej inteligencji znacząco przewyższają ryzyka

putting the capabilities of Stable Diffusion into the hands of the public would result in the technology providing a net benefit, in spite of the potential negative consequences

Drugim wątkiem jest chęć odebrania tej technologii megakorporacjom. Ja zawsze z pewnym dystansem podchodzę do takich deklaracji, zwłaszcza gdy padają z ust prezesa...

intention behind the open availability of Stable Diffusion is to end corporate control and dominance over such technologies

W tym miejscu warto przypomnieć, że są megakorporacje które w mistrzowski sposób monetyzują i zarządzają oprogramowaniem Open Source. Google posiada dziewięć produktów z których korzysta ponad miliard osób. Dwa z nich są Open Source: Przeglądarka Chorme oraz system operacyjny Android. Kubernetes - podstawowe rozwiązanie wykorzystywane w infrastrukturze chmurowej też jest otwarte.

Lista modeli LLM Open Source

Tutaj znajdziesz otwarte repozytorium zbierające modele LLM (zobacz słowniczek AI jeśli mieszają Ci się te skróty). Modele te udostępniane są na licencji komercyjnej - więc możesz je uruchomić i wykorzystywać w swojej aplikacji.

Pojawia się wątek praw autorskich - niektóre modele były uczone na danych objętych prawami autorskimi więc nie powinny być udostępniane na otwartej, komercyjnej licencji. Nie zakładam złej woli developerów, to jest właśnie urok decentralizacji. Miej to na uwadze opierając swój biznes o takie rozwiązanie.

Wrap up

Uważam, że modele otwarte będą bardzo popularne, być może nawet zdominują rynek. Być może będzie to wynikało z potrzeby transparencji w tych rozwiązaniach - Google czy OpenAI będą chciały pokazać, że dbają o bezpieczeństwo i jakoś swoich rozwiązań. Nie wierzę, że uciekniemy od megakorporacji, raczej upowszechnimy model monetyzacji Open Source przez Google. Z jednej strony, czy nam się to podoba czy nie, duże firmy zapewnią oczekiwaną jakość rozwiązań - ta potrzeba będzie szczególnie mocna właśnie ze względu na potencjalne zagrożenia. Ekosystem Apple jest ściśle zamknięty między innymi ze względu na bezpieczeństwo. Potrafię sobie wyobrazić, że będą modele wytrenowane tylko na dobrych, legalnych, super-jakościowych danych.

Poza jakością danych fosą, na brak której narzekał Googler, będą regulacje. Wydaje mi się, że prędzej czy później wykorzystanie sztucznej inteligencji będzie kontrolowane a megakorporacje będą potrafiły się dostosować do wymogów prawnych. Zwłaszcza jeśli faktycznie AI rozpocznie rewolucje na rynku pracy białych kołnierzyków. Taka tektoniczna zmiana mocno łączy mi się z koncepcją dochodu podstawowego, ale to temat na inny tekst.